↑

↑

↑

h

i

g

h

e

r

p

r

e

c

i

s

i

o

n

>>> higher recall >>>

wp/>>>

Per mentalizzarci ragioniamo su un esempio di riferimento

il classificatore di immagini quando valuta la singola immagine puo'

sbagliare

valutare gatto un n-gatto. Falso positivo.

Aggiunge dei falsi all'insieme selezione.

valutare n-gatto un gatto. Falso negativo.

fa mancare elementi all'insieme selezione.

esattare

gatto al gatto. Pane al pane. Vero positivo.

n-gatto al n-gatto. Vino al vino. Vero negativo.

Gli errori di selezione sugli elementi, producono un errore complessivo sull'insieme selezionato

| dovrebbe | invece |

|---|---|

| contenere solo gatti | contiene anche non gatti |

| contenere tutti i gatti | mancano immagini di gatti |

many customers expect an almost perfect recall. They never want to miss an article about the subjects they are interested in. However precision is not as important (albeit highly desirable), if you get a bit of noise in the article feed, you are usually fine.

Nei vari analoghi casi, l'operazione e' come sopra detta.

high precision: getting all correct, than getting them all.

high recall: getting them all, than getting all correct.

| low recall, high precision | high recall, high precision | |

| ↑ ↑ p |

|

|

| low recall, low precision | high recall, low precision | |

|

>>> higher recall >>> |

||

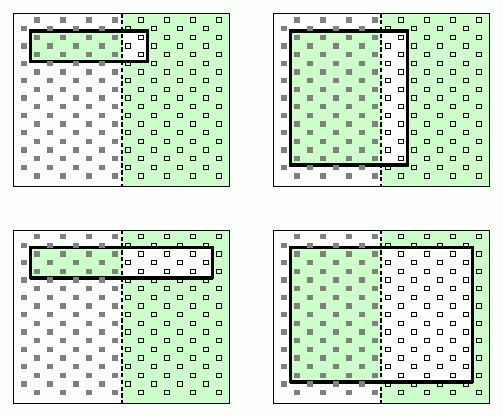

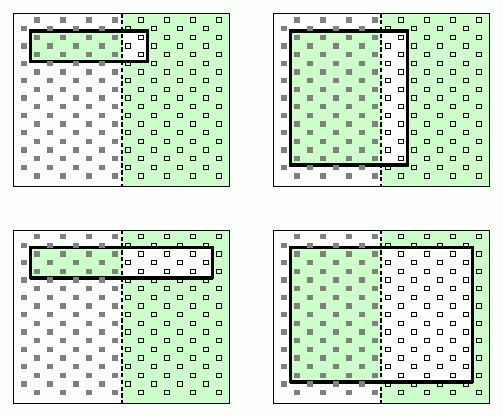

e' un diagramma insiemistico

Il messaggio e' ridondante: basterebbe o il verde o il rettangolo interno.

| ↑ ↑ p |

Low recall, high precision

|

high recall, high precision

|

| Low recall, low precision

|

high recall, low precision

|

|

|

>>> higher recall >>> |

||

it thinks a lot of things are “cats”, who are not .

it thinks a lot of “cats” are “cats”.

So from the set of images we got a lot of images classified as “cats”,

many of them was in the set of actual “cats”

a lot of them were also “not cats”.

it is very picky, and does not think many things are cats.

almost all the images it thinks are “cats”, are really “cats”.

However it also misses a lot of actual “cats”, because it is so very picky.

It is very good: it is very picky, but still it gets almost all of the images of cats.

Precision = tp÷(tp+fp)

The relation between true positives and the total number of true positives and false positives.

Recall = tp ÷ (tp+fn)

The relation between true positives to the total number of true positives and false negatives. [https://en.wikipedia.org/wiki/Precision_and_recall]

These metrics are important in general machine learning, deep learning, NLP Natural Language Processing.

L'insieme di tutte le immagini ha 2 parti

rilevanti/irrilevanti ≡ positivi/negativi ≡ gatti/n-gatti

Il classificatore classifica, anch'esso in binario,

si potrebbero usare gli stessi nomi articolando

v/f valutazione del classificatore

V/F valutazione di riferimento

| V | F | |

|---|---|---|

| v | vV | vF |

| f | fV | fF |

| P | N | |

|---|---|---|

| v | vP | vN |

| f | fP | fN |

insiemistica: elemento appartiene all'insieme

statistica: individuo appartiene alla popolazione

Per selezionare un sottoinsieme:

Insiemistica: proposizione logica applicabile

In generale in pratica: Classificazione di specificazione; classificazione binaria.

In matematica: Assioma di selezione. Assioma di specificazione.

Esempio prototipico, paradigmatico, canonico, classico, tradizionale, ...

Nell'insieme universo, si seleziona un sottoinsieme, tramite una condizione di tipo logico Vero/Falso applicabile ad ognuno degli elementi.

Il sottoinsieme selezionato e' l'insieme degli elementi per cui la condizione risulta vera.

tra tutte le immagini disponibili, il classificatore seleziona quelle volute.

Pero' il classificatore non e' perfetto, quando classifica la singola immagine puo' sbagliare